个人真知灼见篇 | 2024年“AIGC行业发展趋势&研究热点指引”,满满的一箩筐干货送给你!

01-文生图任务在往“高可控、超大分辨率方向发展”。

经历了2023年的快速迭代,当前的文生图算法已经可以在输入恰当的文本提示的情况下生成高精度的图片(SD与MJ就是代表)。但是你可能还存在着这样的一个痛点问题:“如何生层高可控、高分辨率的图片?”

当前很多文生图算法的控制能力还比较弱,很多时候它并不能立马生成你想要的图片,你需要尝试很多次才能生成满意的结果,这期间需要耗时大量的算力成本和人力!除此之外,对于文生图算法的部分应用场景而言,它们期望能够获得超大分辨力的图像,例如:液晶屏显示、电影制作等。

02-图像编辑算法其实也是一种形式的ControlNet,需要你灵活的使用它。

很多朋友可能不太了解图像编辑算法,或者任务图像编辑算法没有太多的用物之地!那只能说你还是不太了解它,不知道它的用物之地。顾名思义,图像编辑算法可以对图像中的部分目标执行增删添改操作。你可以先用文生图算法生成图像,然而生成的这些图像不一定能够满足你的特定需求,这是你可以使用图像编辑算法将其修改成你想要的样子!

它与ControlNet不同的地方在于:ControlNet是在生成之前添加约束,而图像编辑是在生成图像之后修改。2023年的图像编辑算法都已经很强大了,它不仅可以针对图像中的前景、背景、各种目标进行精确的增删添改等;而且甚至可以让静态图片很自然的动起来!现在已经2024年,强大的图像编辑算法简直不要太多了。

04-文生3D任务在往“高精度、高可控”方向快速迭代。

简单回忆下AIGC兴起之前,想要创建一个物体的高精度3D模型,需要耗费大量的时间与经历!首先,需要围绕某个物体旋转360度,并按照特定的角度间隔进行拍照;然后,利用一些多视角算法进行合成;最后,需要重点优化拼接缝隙。

自从有了文生3D算法之后,彻底可以摆脱这些繁琐的操作,你只需要简单利用文字描述下你需要生成的3D目标,文生3D算法就可以帮你生成一个3D模型出来。但是在2023年,文生3D算法生成的模型的精度并不高,而且存在一些区域的缺失等现象。

2024年,高精度的文生3D模型已经出现,淘宝上风靡一时的“给我一张照片,我帮你生成一个3D模型”底层其实就是利用的类似的算法。除此之外,文生3D任务也存在同样的一个问题:即“当前的文生3D模型并不可控,如何高可控的生成3D模型?”

05-文生视频的应用还需要一些时间,不过已经在路上了。文生视频+数字人是个不错的方向。

文生视频可以应用到很多场景,例如:视频创作、社交媒体创作、虚拟主播、VR、AR等。但我个人更看好“文生视频+虚拟人”这个方向,即基于虚拟人的视频生成。国内的虚拟人技术已经比较成熟,不管是大厂,还是创业公司,做虚拟人的公司一抓一大把。如果能将很好的文生视频技术与虚拟人结合,将能够打造出一个爆款产品。阿里放出的EMO就是一个很好的应用样例,让Sora生成的虚拟人开口唱歌与说活。

06-Agent+机器人/手机组合能够发挥意想不到的效果,多Agent协助是个不错的方向。

Agent(代理)是指在某个系统或环境中代表或执行特定任务的实体。在计算机科学领域,Agent通常是指一种软件实体,它能够自主地感知环境、做出决策和执行动作,以达到预定的目标。Agent可以是自主的、智能的,也可以是被动的、简单的。它们可以是独立的程序,也可以是嵌入到其他系统中的组件。Agent通常具有一些基本特征,如感知、推理、决策、执行和通信等。

我相信很多朋友都在期待着GPT-5的出现,那么很多朋友可能都很想知道GPT-5可能会在哪些方面有所突破?个人觉得可能会在以下的结果方面有所突破:

-

GPT-4以及GPT-4-Turbo等大语言模型上面已经可以支持各种各样的问题类型了,基本上已经覆盖了大多数的场景。因而,GPT5可能会更关注于提升这些类型的问答效果,它可能会针对性的收集一些数据来优化当前这些问题的输出效果。

-

GPT-4以及GPT-4-Turbo并不支持输出语音、3D等类型,而语音是人类交流的一种重要媒介,它对大语言模型来说也至关重要!除此之外,我们生活在一个3D场景中,各种3D任务与数据随处可见,它也是一个很刚需的任务。因而,GPT5可能会支持语音以及3D等类型的输入!

毋庸置疑,大语言模型会出现“知识涌现”能力主要与“模型架构和大量高质量的数据有关”。个人认为大量高质量的数据更加重要一些。

随着ChatGPT、GPT-4、GPT-4-Turbo等多语言模型的出现,互联网上面高质量的数据已经被使用的七七八八了,我觉得用“榨干”两个字来形容也不为过。然而,越到模型迭代的后期,需要的数据量更大、需要的数据质量更高,而且需要一些针对特定类型的高质量数据。

09-伴随着高质量真实数据的枯竭,合成数据的重要性越来越凸显。

打个比方,个人认为“数据就像是粮食,人吃不饱粮食干不动活,大模型吃不饱数据回答不出好答案!” 简而言之,大量高质量的数据对大模型而言至关重要,如上面所说,真实场景的数据正在逐渐被榨干,正在枯竭!

解决这个问题有很多的办法,但是我个人认为仅仅依赖于高质量的真实数据来迭代LLM并不是一个理想的解决方案,适量的真实数据+部分合成数据才是一个更好的解决思路。随着UE等合成技术的快速突破,很多行业已经逐步开始利用合成数据来代替部分真实数据,大模型也不例外。

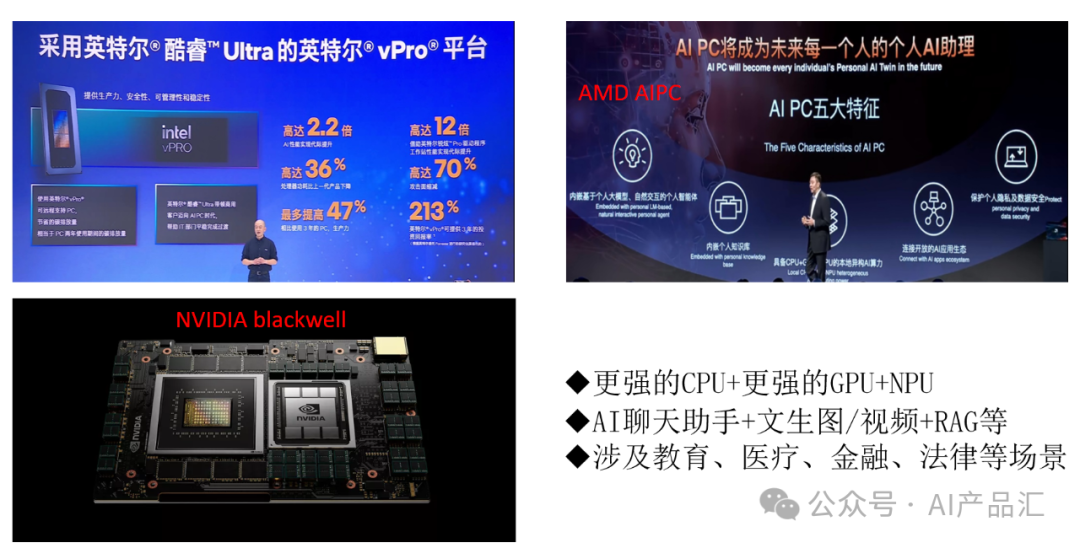

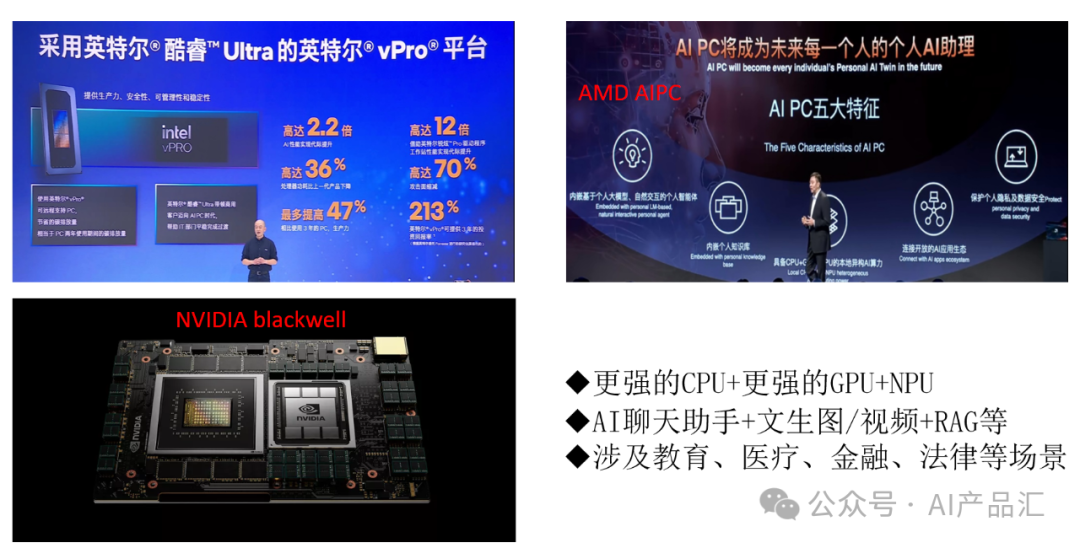

无论是文生图、文生3D等任务,还是大语言模型、多模态大模型等任务,这些AIGC算法都有一个共性:“都需要底层强大的算力支撑”。随着各种AIGC算法在2023年的迭代优化,很多算法在服务端已经可以取得较好的效果。然而现实生活中,服务端仅仅占据了一少部分的应用场景,AIGC算法的大量应用需求仍在端侧。

那么,端侧部署AIGC算法,需要满足两个基础条件:1)模型压缩加速技术(量化、蒸馏、裁剪、编译器优化等);2)强大算力的支持。由于大模型的抗干扰能力更强,int4类型已经被应用到该领域,这可以在很大的程度上加速AIGC算法的落地进程。除此之外,在某些端侧场景是可以为AIGC提供比较强大的算力支持。

“个人PC、高算力的自动驾驶平台、高算力的机器人平台、高配手机”可能是几个在2024年可以在端侧落地AIGC算法的场景。

-

2024年3月份,Intel、AMD等众多硬件厂商都提出了一个AIPC时代的概念,说的更直白一点就是:“AIPC时代的PC可以支持直接在端侧执行某些AIGC算法,付出的代价是需要增加一颗高性能的NPU,专门来执行一些复杂的AIGC算法的推理任务”。你可以在这些带有NPU的PC上面执行一些“文生图、大语言模型、RAG等”多种任务,无需担心个人隐私问题。

-

对于自动驾驶的座舱域而言,它更关注娱乐与放松,更倾向于利用一些前沿的AI&AIGC算法来提升用户的交互与使用体验。大语言模型落地到这里面再适合不过了,大语言模型可以极大的提升用户的交互与沟通体验。很多自动驾驶平台上面都配备了高算力的平台(英伟达的Orin),算力高达上百T,因而这个场景是可以考虑落地一部分经过轻量化的AIGC算法。

-

2024年初,曾经掀起了一波四足机器人和人形机器人的热潮。对于这些机器人而言,它不仅需要强大的感知、定位、规划、控制能力,而且需要强大的交互、沟通等能力。大语言模型恰恰可以满足后者的需求,它的加入势必会让这些机器人变得更加智能与聪明,能让它们的交互体验再跨越一个新的台阶。这些机器人平台上面一般都配备了比较强大的算力,这可以满足部分轻量级LLM的需求。

-

手机无疑是一个最通用的端侧产品,AIGC算法的终极目标是服务与人类,那么手机端一定是一个很好的赋能场景。伴随着模型量化、蒸馏、编译器优化等技术的逐渐成熟,性能还可以的轻量级AIGC算法逐渐出现,将这些算法部署到手机端是一个不错的研究方向。不过,个人建议先从苹果手机下手,毕竟它的底层芯片更强大一些!

12-当你的AIGC算法满足了精度需求之后,你可能就需要考虑如何加速降本了!

随着很多AIGC子任务逐渐满足了大多数场景的精度需求之后,加速与优化它可能会逐步变成你的关注热点。在应用文生图应用的过程中,你可能会有这样的感受:“我花了那么多钱搞了个高端的显卡,跑个文生图应用需要几十秒的时间,这个时间我忍受不了,但是我又不想在设备上花太多的钱!” 假如你遇到了这种情况,我建议你可以考虑一下花点时间去选择一款最适合自己应用的LLM推理框架,它决定着你的推理速度的上限!

13-不久的将来,手机端是否也会增加一个NPU用来做AIGC算法推理?

个人认为,手机端是AIGC应用的一个重要场景。虽然当前手机的硬件已经算是高配了(八核ARM CPU处理器+GPU),但是这并不能满足LLM等其它AIGC算法的算力要求。除此之外,ARM CPU与GPU并不适合用来执行LLM推理等任务。因此,要想在手机端高效的执行LLM推理等AIGC任务,增加一个专门做推理加速的NPU单元是一个刚需。

然而,在手机上添加NPU需要一些时间,不仅需要解决端侧NPU的研发与应用问题,而且需要考虑成本、功耗等问题。除此之外,需要一个高效的端侧LLM推理框架的支持,而这个条件还不是很成熟。

总而言之,手机端未来可能也会增加一个专门做LLM推理任务的NPU硬件单元,但是需要时间去开发与适配,众多的手机厂商一定会让它尽快到来!它的到来一定会引爆AIGC算法在手机端的应用速度。

14-文末福利

注意事项:以上的所有观点仅仅是我个人的思考,可能有很多不完善或者不成熟的地方,欢迎大家一起探讨与补充!

关注我,AI热点早知道,AI算法早精通,AI产品早上线!

欢迎你的加入,让我们一起交流、讨论与成长!

若二维码失效:关注公众号--》交流分享--》联系我们(备注:AI产品汇)

禁止私自转载,需要转载请先征求我的同意!